高中生开发Minecraft基准测试网站,用游戏挑战AI模型

- 其他资讯

- 2周前

- 132

- 更新:2025-03-21 20:04:00

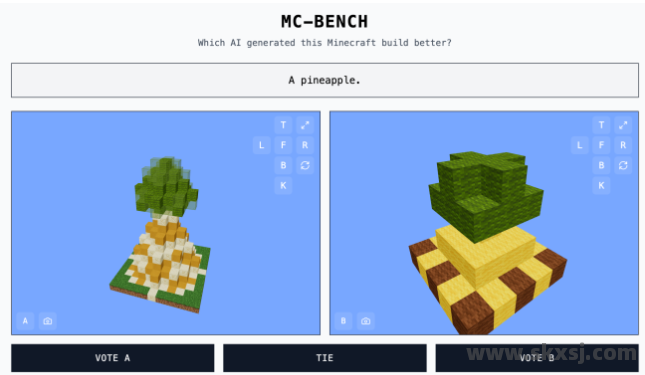

一名高中生开发了一个名为“Minecraft Benchmark(MC-Bench)”的网站,旨在让AI模型在Minecraft中展开创意挑战。由于传统的AI基准测试方法已显不足,开发者们开始尝试更有趣的方式来评估生成式AI的能力,而Minecraft正是他们选择的平台。

MC-Bench是一个合作项目,目标是让AI模型通过在Minecraft中完成特定任务来互相竞争。用户可以通过投票选出表现更好的AI模型,而最终结果会显示每个作品是由哪个人工智能生成的。

对于网站创始人、12年级学生Adi Singh来说,Minecraft的价值不在于游戏本身,而在于它是一款广为人知的游戏——它是全球销量最高的电子游戏之一。即使是没有玩过Minecraft的人,也能轻松评估AI生成的菠萝块是否出色。

“Minecraft让人们更容易直观地看到AI的进步,”Singh在接受TechCrunch采访时说,“人们对Minecraft的外观和氛围已经非常熟悉了。”

目前,MC-Bench已有8名志愿者参与。包括Anthropic、Google、OpenAI和阿里巴巴在内的多家公司已为该项目提供资金支持,用于在其产品中运行基准测试。

Singh表示,当前的测试还比较简单,主要是对比AI模型与GPT-3时代的进步,但未来可能会扩展到更复杂的长期任务和目标导向型任务。“游戏只是测试AI推理能力的一种媒介,相比现实世界,它更安全、更易于控制,因此更具优势。”他说。

除了Minecraft,其他游戏如《精灵宝可梦红》、《街头霸王》和《你画我猜》也被用于AI的实验性基准测试。部分原因是,设计AI基准测试本身就是一个充满挑战的领域。

研究人员通常会在标准化测试中评估AI模型,但许多测试项目对AI来说过于简单,因为模型在训练过程中就被设计成擅长解决某些特定类型的问题,尤其是需要死记硬背或基本推理的任务。

例如,OpenAI的GPT-4在LSAT中取得了88%的成绩,但在识别“strawberry”这个词中有多少个“R”时却表现不佳。Anthropic的Claude 3.7 Sonnet在软件工程基准测试中的准确率为62.3%,但在玩《精灵宝可梦》时却比大多数五岁儿童还要差。

从技术角度看,MC-Bench是一个编程基准测试,因为模型需要编写代码来完成提示中的构建任务,例如“雪人弗罗斯蒂”或“原始沙滩上迷人的热带海滩小屋”。但对于大多数用户来说,评估雪人的外观比研究代码更容易,这也使得该项目更具吸引力,并有可能收集更多关于哪些模型表现更好的数据。

当然,这些分数是否能显著影响AI的实际应用仍有待讨论。但Singh坚信,这将是一个强烈的信号。

“目前的排行榜与我自己使用这些模型的经验非常接近,这与许多纯文本基准测试不同,”Singh说,“也许(MC-Bench)可以帮助公司了解他们是否正在朝着正确的方向前进。”

有话要说...