个人电脑行业正在输掉本地人工智能的竞赛

- 电脑快讯

- 10个月前

- 104

- 更新:2024-02-27 19:33:51

仅支持支持本地大型语言模型、生成式AI等的AI硬件是不够的。硬件供应商也需要挺身而出,为这些本地人工智能应用程序充当中间人–如果不是直接的开发者的话。

高通几乎做到了。在MWC 2024(前身为世界移动通信大会,也就是世界上最大的移动贸易展会之一)上,该公司本周宣布推出高通AI Hub,这是一个专门为高通和骁龙平台优化的75多个AI模型的储存库。高通还展示了一款拥有70亿个参数的本地LLM,它运行在一台(可能是骁龙驱动的)PC上,可以接受音频输入。最后,高通演示了在骁龙手机上运行的另外70亿个参数的LLM。

这一切都很好,但更多的PC和芯片供应商将不得不展示人工智能的真实例子。高通的AI Hub是一个良好的开端,尽管它是开发人员的中心。但芯片和个人电脑供应商要说服用户使用本地人工智能的唯一方法是让它变得简单、廉价等。然而,很少有人挺身而出这么做。

个人电脑行业倾向于抓住任何可能的趋势,因为个人电脑硬件的销售一直被智能手机、云和其他威胁其主导地位的设备所削弱。虽然笔记本电脑和Chromebook的销量在疫情期间飙升,但它们已经艰难地回到了现实。认为你将需要一台本地个人电脑来运行下一件大事–人工智能–并为高端硬件买单的说法,应该会让个人电脑行业垂涎三尺。

但人工智能的第一个例子是在云中运行的,这让个人电脑行业落在了后面。这感觉像是我反复强调的一点,但我要再说一遍:微软似乎还没有特别投资于本地人工智能。所有以微软的“Copilot”品牌命名的东西都在云中运行,通常需要订阅或至少需要一个微软账户才能使用。(Copilot可以与Windows本地帐户一起使用,但在强制您登录才能继续使用之前,只能使用有限的次数。)

大多数人可能根本不相信他们需要使用人工智能,更不用说在电脑上本地运行了。这是芯片和硬件供应商需要解决的问题。但解决方案不是硬件,而是软件。

答案是应用程序:大量的应用程序

微软去年在微软商店应用程序中引入了AI Hub,但即使在今天,它也感觉有点平淡无奇。大多数聊天机器人应用程序实际上都运行在云中,需要订阅–当然,这是没有意义的,因为Copilot基本上是免费的。Adobe Lightroom和ACDSee等应用程序也是如此;它们也是基于订阅的,这是本地应用程序可以通过利用本地PC的强大功能来避免的。

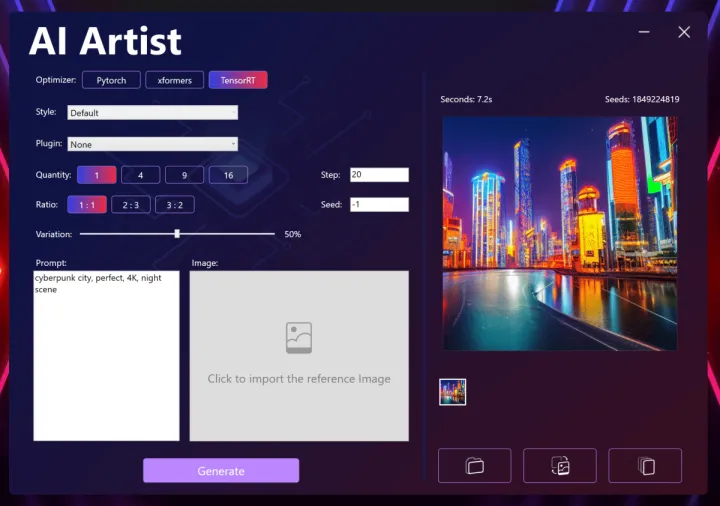

这就留下了硬件供应商来传递火炬。一些公司已经做到了:例如,MSI为其最新的MSI Raider GE78游戏笔记本电脑提供了一款“AI Artist”生成性AI应用程序。虽然它有点笨重和缓慢,但至少它提供了可信供应商的一键安装过程。

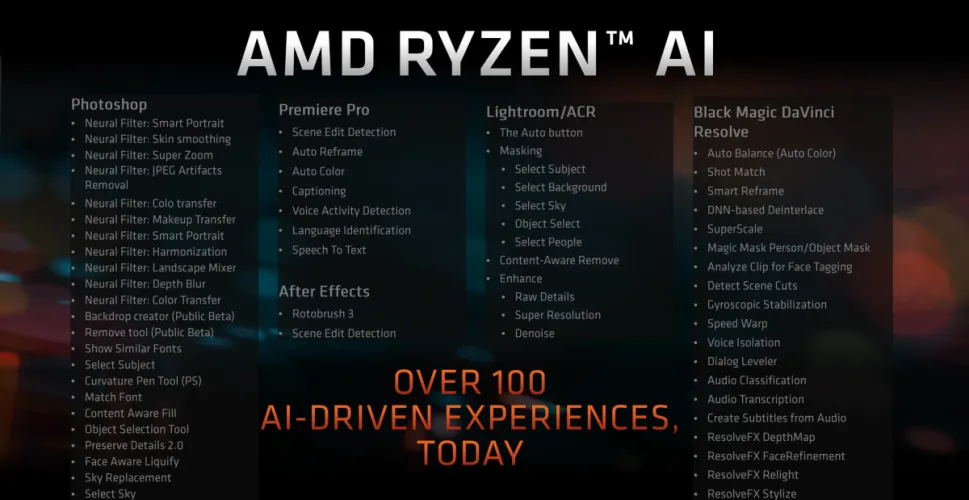

但这是当地人工智能沙漠中的一片绿洲。AMD和英特尔都在吹嘘他们的芯片在像Llama 2这样的人工智能语言模型上的性能。对于那些已经尝试过人工智能聊天机器人并熟悉其中一些不同模型及其工作原理的人来说,这是有意义的。例如,AMD专门列出了哪些应用程序利用了它自己的NPU,并将其命名为Ryzen AI。

恕我直言,这还不够好。英特尔去年推出了一只人工智能发展基金,这还不够。芯片供应商需要做的是把它们送到消费者手中。

多么?有一种方法已经被证明是正确的:试用由人工智能驱动的应用程序,如Adobe Photoshop、BlackMagic的DaVinci Resolve或Topz。传统上,客户不喜欢臃肿的软件,但我认为,如果PC行业要推销AI PC,他们将不得不尝试推出一款倾向于它的创建者级PC。与其用“Intel Inside”来运作,不如开始营销“AI捆绑包”。专注于软件,而不是硬件。也开始在盒子的外面贴上应用程序的标识。Adobe愿意在一台“Photoshop认证”的个人电脑上盖上自己的印记吗?这是一种想法。

否则,我会建议英特尔提出一个更好的想法:回归游戏捆绑包。今天,英特尔和AMD都可能将像《刺客信条:幻影》这样的游戏与购买合格的CPU或主板捆绑在一起。但不久前,你可以免费下载几款游戏,展示CPU的能力。(下面是2018年的MSI示例。)

在本地运行人工智能确实提供了一些令人信服的优势:例如隐私。但Copilot和Bard的便利性因素是使用这些经过清理的工具的有力论据。消费者是反复无常的,他们也不会在意,除非有人告诉他们应该这样做。

如果AMD、英特尔以及最终的高通计划让本地人工智能成为现实,他们将不得不让这一选择变得简单、廉价和无处不在。在人工智能炒作列车已经全速前进的情况下,他们需要在昨天做到这一点。

有话要说...