流星湖NPU:英特尔本地人工智能处理专用硅片

- 电脑快讯

- 1年前

- 155

- 更新:2024-01-25 17:17:38

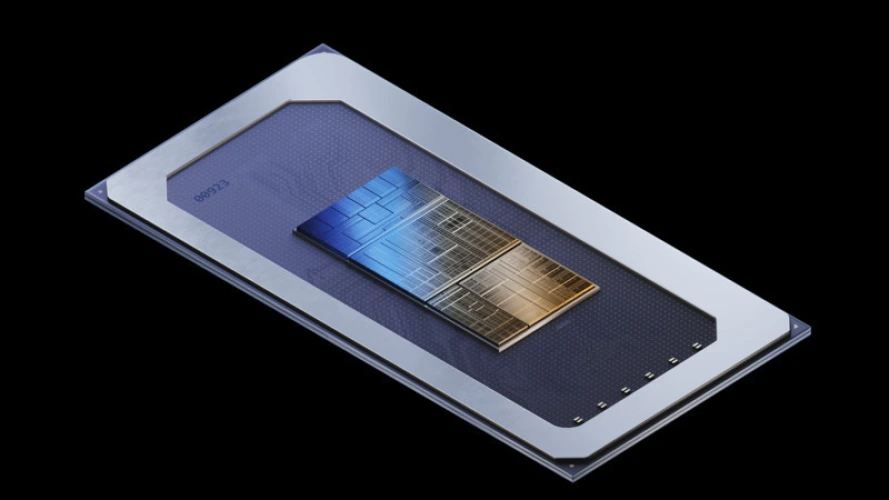

当英特尔的“流星湖”处理器发布时,它们不仅将配备分布在两个芯片上的CPU核心,还有一个芯片上的GPU部分,而且还将配备该公司有史以来第一个致力于人工智能工作负载的神经处理单元(NPU)。

根据英特尔的说法,NPU意味着像稳定扩散这样的生成性人工智能程序,或者今天的聊天机器人在本地托管的语言模型上工作,可以在流星湖笔记本电脑上本地运行,而不会受到性能缓慢、质量差或严重的电力需求的困扰。

英特尔负责SOC设计的总经理蒂姆·威尔逊表示:“在英特尔,我们的目标是让人工智能民主化,围绕标准化界面构建,让世界上任何人、任何地方都能接触到它。”

在基于人工智能的工作负载方面,由此产生的NPU有望提供比英特尔上一代芯片高达8倍的能效。该公司在2023年的Computex上预览了这项技术的运行情况,当时NPU也被称为VPU,或“多功能处理单元”。现在,该公司正在分享更多细节,包括架构。

新NPU的形态

你已经可以使用PC的GPU来支持人工智能工作负载,但这样做会耗电,这对于电池有限的笔记本电脑这样的计算环境并不理想。(当然,它在桌面环境中也可能是一种浪费。)英特尔的解决方案是NPU,据专门研究计算机图形的英特尔研究员汤姆·彼得森说,NPU已经“针对长期持续的、中等功率的、密集的应用程序进行了优化”。“因此,如果你正在进行持续的工作负载,那么NPU是为你而设计的。”这种NPU优化任务的一个例子可能是使用人工智能图像生成器从本地托管的模型中大量生成大量图片。

NPU本身通过芯片或瓷砖(具体地说,芯片上的四个芯片之一的SoC瓷砖)连接到流星湖处理器上,其中还包含一个被称为“低功率岛”的部分。该岛拥有专为低功耗工作负载设计的高效内核(E-core)的特殊子集。而Compute Tile则拥有与上一代英特尔处理器相似的普通性能内核和E-core。(请转到我们的流星湖解说员那里,了解更多关于新芯片架构的信息,包括一块一块的细分。)

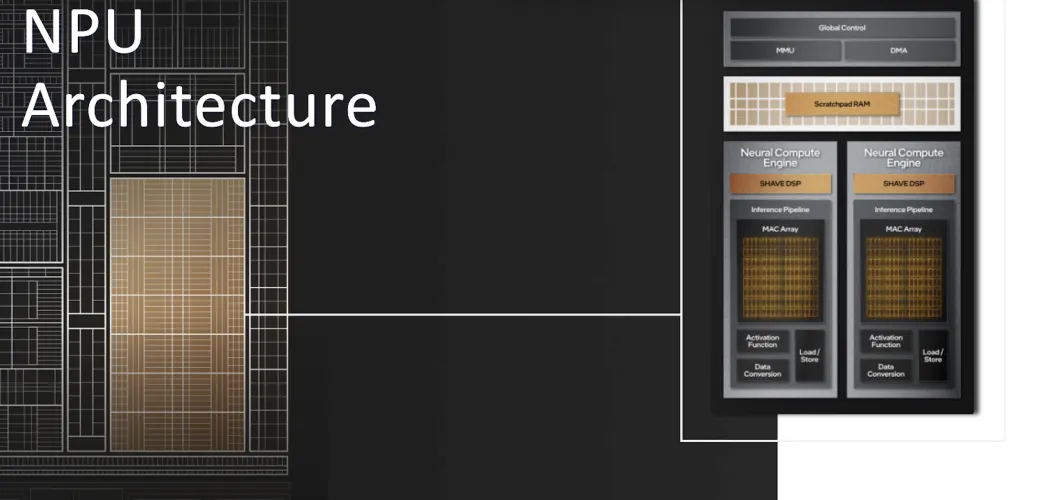

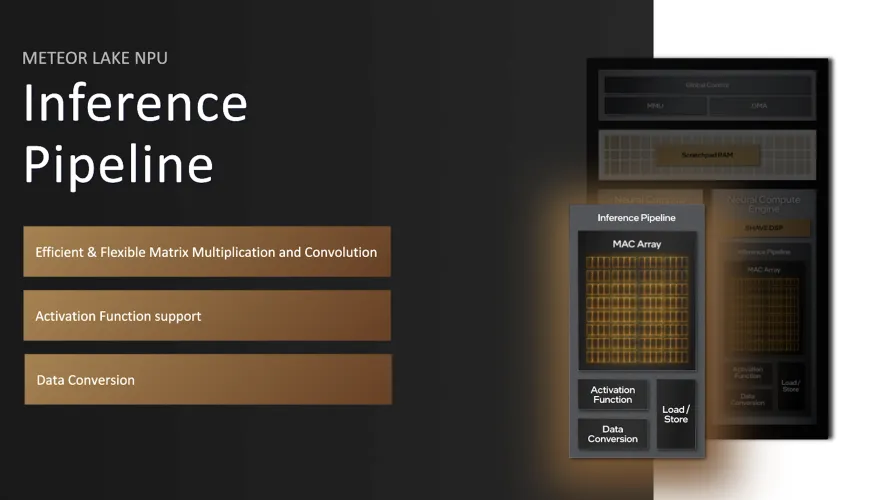

NPU将在两个神经计算引擎上运行,这两个引擎可以各自处理自己的人工智能工作负载,也可以联合起来处理单个工作负载。每个引擎都包含一个推理管道,可以处理传入数据并对其进行转换。

“这些东西都是用我们的软件编写的,并在顶部提供了行业标准的API,使其非常容易在软件中采用,”彼得森补充道。NPU也是独立的,它将作为自己的计算设备显示在Windows任务管理器中,与CPU和GPU一起显示。英特尔在其面对面的流星湖演示中展示了这一点,它邀请PCMag在Computex上加入。他说:

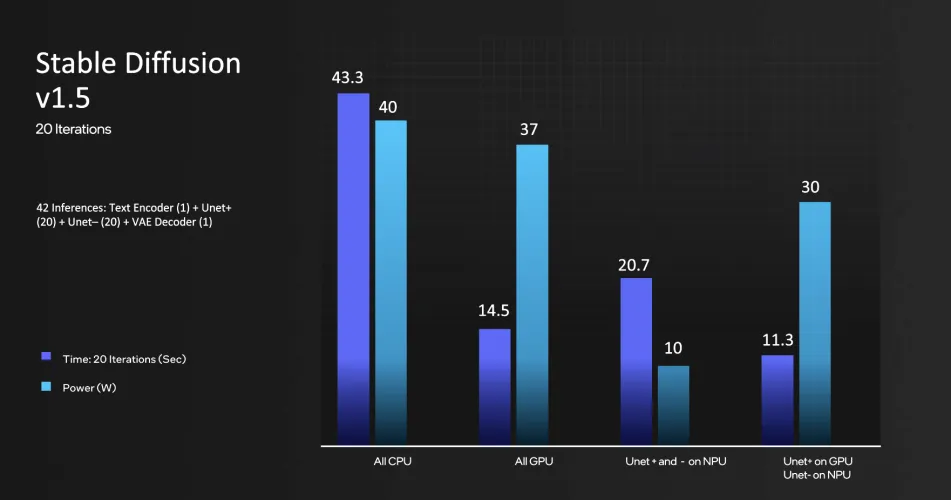

在新闻发布会上,英特尔还展示了流星湖PC在运行AI图像生成器稳定扩散时的性能基准。当单独使用Meteor Lake的集成GPU时,该处理器实际上可以相对快速地运行样本稳定的扩散工作负载,运行速度为14.5秒,但具有显著的功率负载(37瓦)。

相比之下,英特尔声称,NPU可以在略长的20.7秒内完成相同的稳定扩散任务,但功耗只有10瓦,大大提高了电源效率。但如果你优先考虑速度,处理器可以同时利用GPU和NPU来运行稳定的扩散工作负载,以低于仅30瓦的速度在11.3秒内完成扩散工作,这是最快的速度。

为什么是神经处理器?

尽管NPU希望利用生成性人工智能的崛起,但它也代表了英特尔对其他芯片制造商在自己的芯片上集成专用人工智能处理的回应。也许最值得注意的是苹果,众所周知,它放弃了英特尔硅片,转而开发基于ARM架构的处理器。结果是2021年的S苹果M1芯片

该公司拥有自己的神经引擎,这是一组专门为基于人工智能的工作而设计的计算核心,比如照片编辑和增强现实体验。与之类似的是,AMD最新的Ryzen 7000系列移动处理器的子集包含一个专门的人工智能硬件元素,该芯片制造商将其称为Ryzen AI。

当然,许多人工智能程序,如ChatGPT或图像生成器,已经在互联网上运行,由远程服务器通过云服务提供支持。但英特尔仍然看到了在消费者个人电脑上直接运行某些人工智能工作负载的机会,理由是好处包括更大的隐私,可能更好的延迟,以及绕过为计算能力支付第三方服务的需要。

尽管如此,英特尔对NPU的确切规格一直保持沉默。我们还想知道,随着英特尔对其酷睿处理器的命名系统进行全面改革,NPU是否会成为某些英特尔芯片的独家产品。展望未来,英特尔将销售标准酷睿芯片和一种名为酷睿超级的新高端产品,它将获得一些独特的功能,包括人工智能支持的功能。

尽管目前还没有具体的芯片型号,但流星湖很可能会首先出现在笔记本电脑上。但你可以预计,NPU最终也会进入英特尔的台式机芯片。“我们通过NPU、GPU和CPU将人工智能带到桌面客户端和移动客户端,”彼得森补充道。所以,把这个新的首字母缩略词“NPU”留在你的候选词汇清单上,以备将来使用。

有话要说...