AMD准备使用图形处理器挑战NVIDIA在可生成人工智能市场的主导地位

- 电脑快讯

- 1年前

- 129

- 更新:2024-01-25 16:40:10

NVIDIA一直主导着能够训练生成性AI程序的芯片市场,但AMD现在正试图通过一款新的企业级GPU来夺取自己的份额。

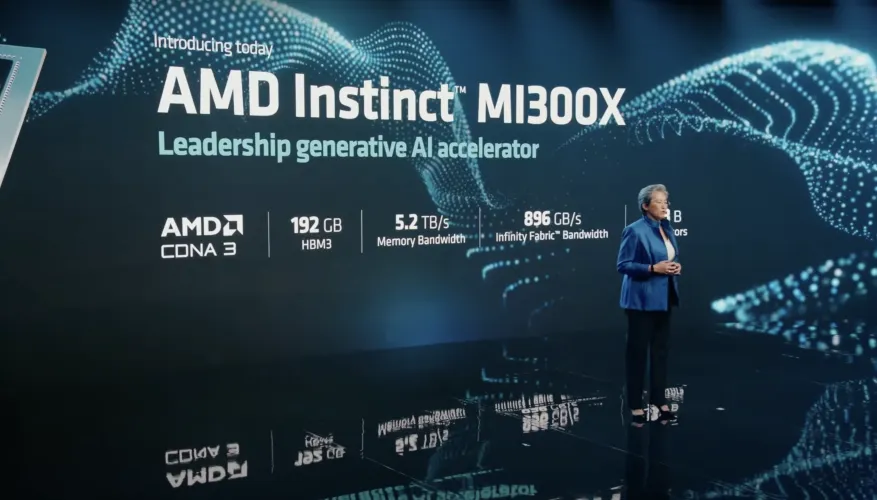

该公司今天宣布推出AMD Instsitive MI300X,这是一款所谓的“加速器”芯片,旨在训练大型语言模型,这些模型可以为OpenAI的ChatGPT等程序提供动力。

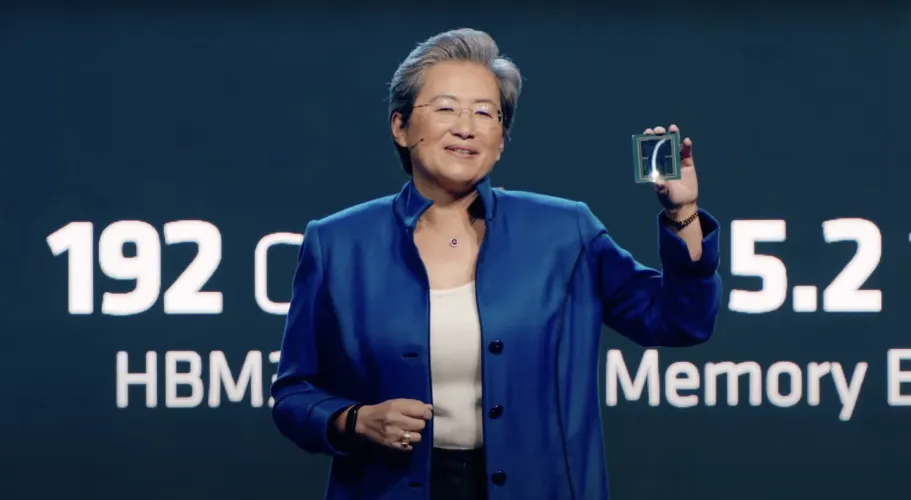

AMD首席执行官丽莎·苏在该产品的揭幕仪式(新窗口打开)上表示:“人工智能真的是塑造下一代计算的决定性技术,坦率地说,它是AMD最大、最具战略意义的长期增长机会。”

MI300X以AMD专注于数据中心的CDNA 3(在新窗口中打开)架构为基础,旨在用于基于AI的工作负载,但MI300X采用了高达192 GB的HMB3内存,试图击败竞争对手。客户将能够将8个MI300X加速器整合到一个系统中,使GPU能够在竞争中训练更大的AI模型。

苏说:“对于最大的型号,它实际上减少了你需要的GPU数量,显著加快了性能,特别是在推理方面,同时还降低了总拥有成本。”

MI300X还基于AMD的另一款专注于人工智能的芯片MI300A,该芯片计划用于超级计算机。不同的是,该公司更换了MI300A中的Zen 4 CPU芯片,将MI300X变成了纯GPU处理器。

“你可能会看到它看起来非常非常像MI300A,因为基本上我们去掉了三个芯片,装上了两个(GPU)芯片,我们堆叠了更多的HBM3内存,”苏补充道。我们真正为产生式人工智能设计了这款产品。

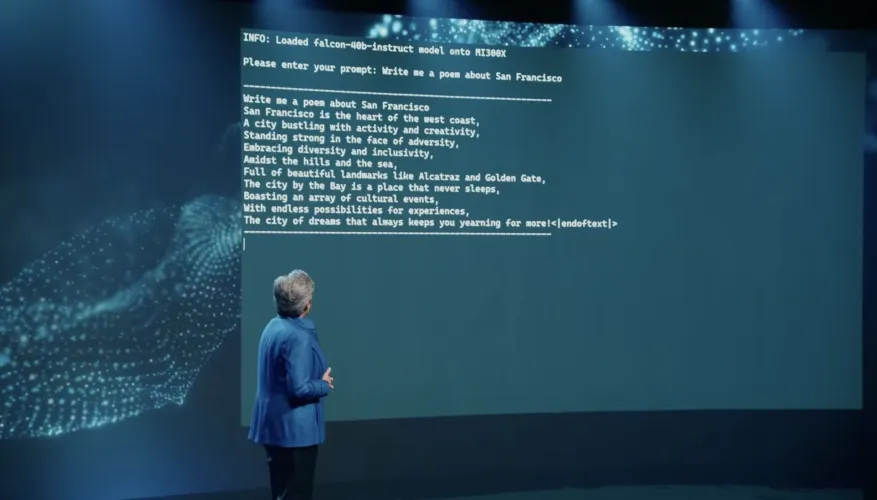

在一次演示中,Su还展示了一台配备192 GB内存的MI300X,它运行着开源的大型语言模型Falcon-40B。该程序被要求写一首关于旧金山的诗,它在几秒钟内就创建了文本。

本文由 @舒克先生 于2024-01-25发布在 舒克先生,如有疑问,请联系我们。

有话要说...