微软招募人工智能增强PC安全并阻止黑客

- 电脑快讯

- 1年前

- 154

- 更新:2024-01-25 16:29:20

人工智能已经被应用于一长串工具:人工智能艺术,人工智能聊天机器人,甚至控制你的家的人工智能助手。现在,微软也在通过其新的安全Copilot功能将人工智能安全添加到列表中。

如果你曾经在你的电脑上管理过(或者,更有可能是没有)你自己的安全,你可能只知道确保你的杀毒软件是最新的。不过,如果你的电脑被黑客入侵了,那就完全是另一回事了。突然,你被推入一个陌生的世界,这需要你做出几个有压力的、立即做出的决定,你必须做出正确的决定。

在这种情况下,让某人或某事引导你了解发生了什么,该做什么,以及如何防止这种情况再次发生在你或其他人身上,这将是非常有帮助的。安全Copilot是微软为这项工作提供的工具,它使用OpenAI的新GPT-4聊天界面来帮助企业IT员工在潜在响应的迷宫中导航。

是的,企业IT员工。目前,微软只向企业客户提供其Security Copilot。但我们当然可以希望微软也能为消费者发布类似的产品。这就是它的工作原理。

首先,这与推动必应聊天等消费者应用程序的大型语言模型(LLM)不同。微软开发的Security Copilot具有特定于安全的模型,并根据安全专业人员使用的知识和术语进行了调整。微软还已经将其连接到自己的安全产品上–微软表示,最终,Security Copilot也将能够与第三方安全解决方案集成。

最后,它是最新的-尽管大多数消费者实施的GPT-4(Bing Chat和ChatGPT等)在2021年之前都只“知道”事实,但微软表示,Security Copilot不断获得微软每天看到的65万亿威胁信号。微软在一篇博客文章中表示,它有越来越多的独特技能和提示可供安全团队利用。

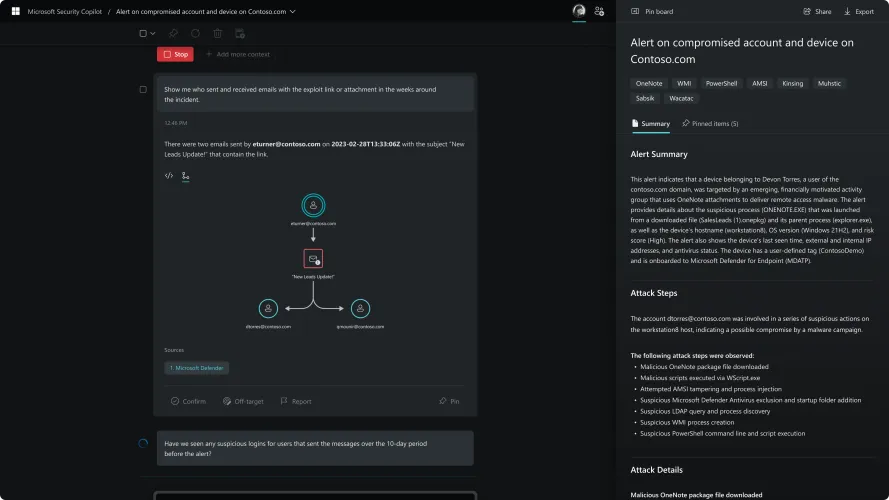

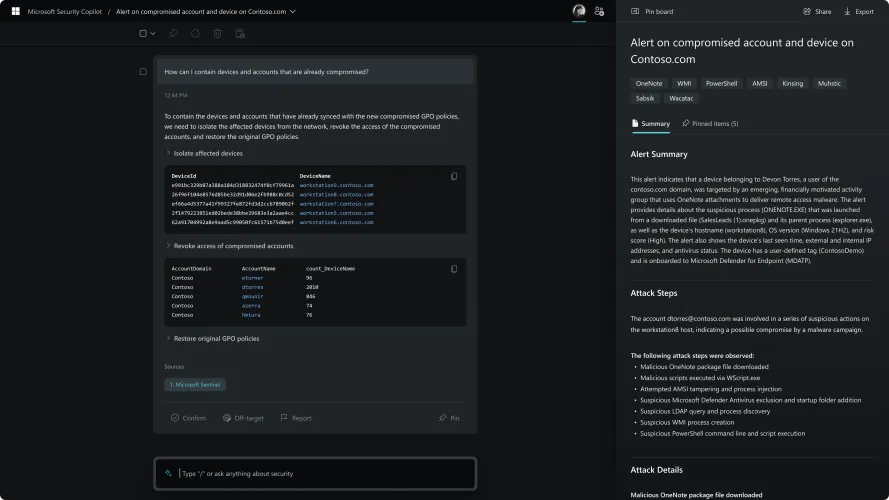

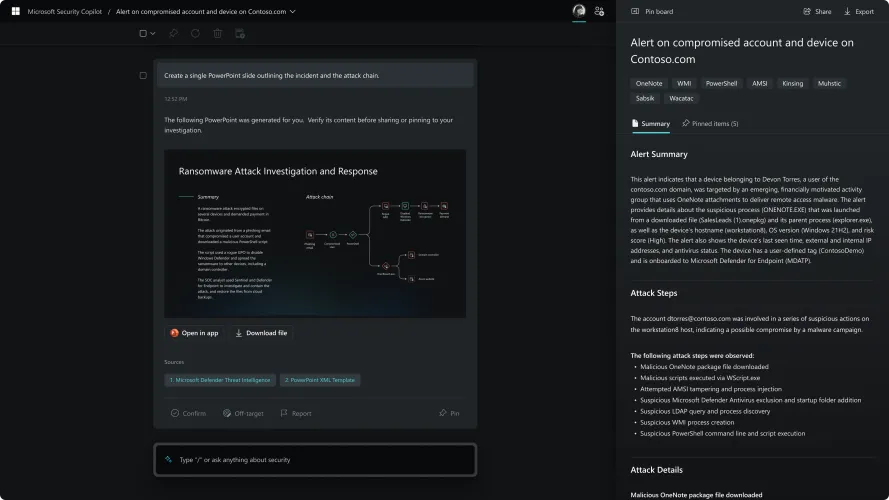

微软表示,使用Security Copilot的优势在于,它的语言模型可以用来检测攻击正在发生的原本难以察觉的信号,并正在不断学习提高这些技能。该公司展示了如何将Security Copilot用作识别问题并缓解问题的助手。

然而,熟悉ChatGPT、Bing Chat、Google‘s Bard或其他人工智能聊天机器人的人都知道,人工智能有时会对可能不真实的事实产生幻觉–比方说,当用户正确理解亚伯拉罕·林肯在2000年并未被选举下台时,这并不是一个关键问题。但当安全专业人员不太确定部门或用户或电子邮件可能有可疑活动附加到他们的电子邮件或共享文件时,这是一个更令人担忧的问题。

微软的回应并不完全令人信服。微软表示:“安全副驾驶并不总是万无一失。”“人工智能生成的内容可能包含错误。但Security Copilot是一个闭环学习系统,这意味着它不断地从用户那里学习,并让他们有机会通过直接内置到工具中的反馈功能给出明确的反馈。随着我们继续从这些互动中学习,我们正在调整其回应,以创造更连贯、更相关和更有用的答案。

当然,微软没有解决在人工智能与人工智能的世界中可能发生的事情,在这个世界里,人工智能辅助攻击者定制了人工智能设计的钓鱼电子邮件和其他针对消费者和企业的攻击。这场“聪明的战争”有望发生在幕后。

然而,这意味着企业可能会在其一小部分用户上测试Security Copilot。对他们或你来说,这不一定是坏消息。如果人工智能真的成为微软希望它成为的工具,消费者和企业都将不得不相信它知道自己在说什么,并且可以做人类的工作。如果世界顶级企业最终信任Security Copilot,这可能会向你保证,人工智能也可以帮助保护你的PC。

有话要说...